Iniziamo con questa citazione di Borges per far comprendere, con un esempio forse paradossale, come la disponibilità di enormi moli di dati non sempre rappresenti un vantaggio. Ireneo Funes, condannato a una prodigiosa capacità di registrare e ricordare anche il più piccolo dettaglio del suo universo, sarebbe stato incapace di riconoscere un suo familiare la mattina dopo perché nella notte, mentre dormiva, la disposizione dei capelli era cambiata. Quando la mole di dati da “processare”, di cui, per fortuna o purtroppo, tutti noi disponiamo, è smisurata, possiamo essere incapaci di creare categorie o cogliere regolarità. Questa incapacità, associata alla mancanza di strumenti per dare un senso alla vastità di dati, può seriamente menomare la nostra possibilità di comprendere e spiegare i fenomeni che ci circondano. In ultima analisi la nostra capacità di anticipare il futuro e fare previsioni.

Non era di questo avviso, Chris Anderson, che nel 2008, allora direttore della rivista Wired, scrisse un pezzo intitolato provocatoriamente “The end of theory” (vd. link sul web). Anderson sosteneva, al contrario, che l’enorme abbondanza di dati, unita alle straordinarie capacità computazionali di cui disponiamo, potesse dar luogo ad algoritmi di machine learning capaci addirittura di surclassare gli esseri umani e la loro capacità di costruire teorie. L’affermazione chiave (argomentata principalmente attraverso le scoperte prodotte pochi anni prima dal sequenziamento del genoma umano, vd. p. 34, ndr) era: “Le correlazioni sostituiscono la causalità, e la scienza può avanzare persino senza modelli coerenti, teorie unificate e addirittura qualsiasi tipo di spiegazione meccanicistica”.

Ma è veramente così? Il criterio fondamentale per comprendere la bontà di una teoria o di una costruzione matematica dovrebbe essere la capacità di effettuare previsioni e verificarne l’attendibilità in opportuni contesti. La predizione del futuro rappresenta da sempre una sfida per le nostre capacità cognitive. E anticipare il futuro significa indovinare l’esito più probabile di una data situazione, a partire da un certo numero di possibilità. Una delle strategie più ovvie per effettuare previsioni del futuro è sempre stata quella di appoggiarsi alla nostra esperienza del passato e, in particolare, alla frequenza con cui si sono verificati nel passato determinati eventi. La straordinaria abbondanza di “serie storiche” (cioè l’insieme di variabili casuali ordinate rispetto al tempo) dei fenomeni più disparati, da quelli fisici a quelli riguardanti gli individui e la società, sembrerebbero far ben sperare. Uno dei criteri storicamente considerato più promettente è il cosiddetto “metodo degli analoghi”. Se in una serie temporale passata si scoprissero delle situazioni analoghe a quelle che viviamo oggi, potremmo dedurne, anche in assenza di un contesto teorico ben definito, che il futuro attuale potrebbe non essere molto diverso dal futuro di quel distante passato. Sappiamo ora che così non è e che il metodo degli analoghi è per la maggior parte dei casi fallimentare.

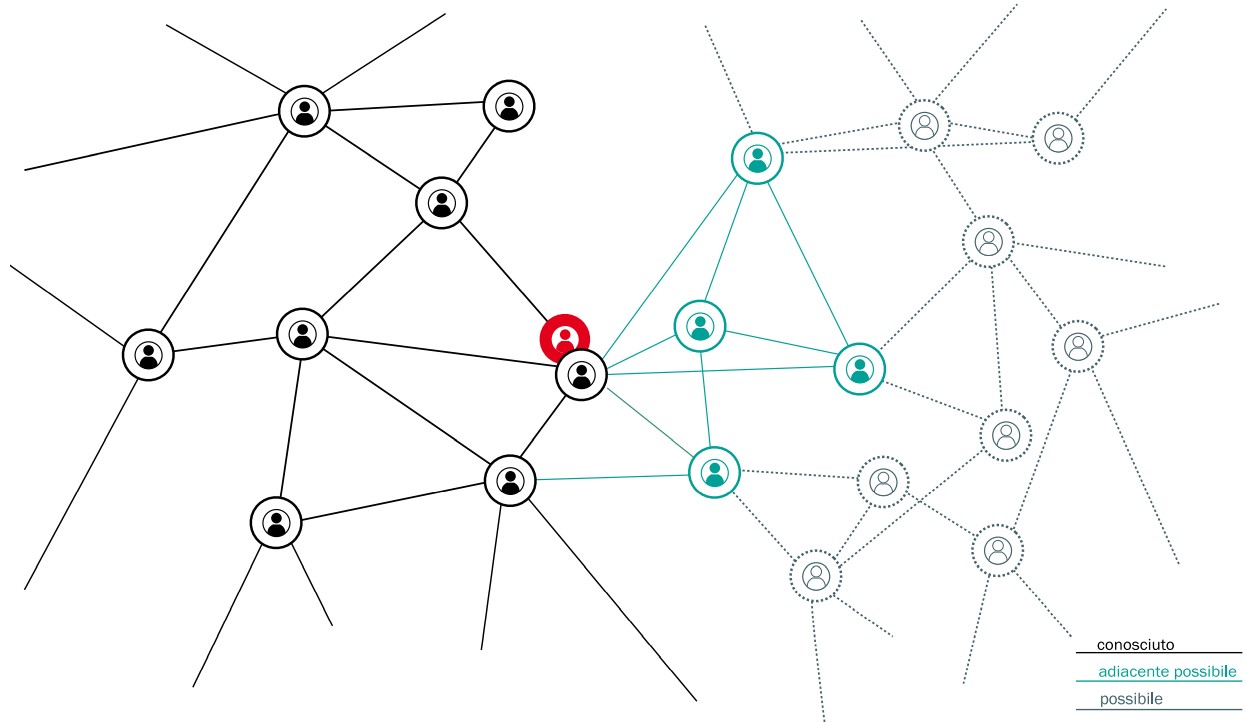

Già James Clark Maxwell, verso la metà del XIX secolo, mise in guardia la comunità scientifica dai rischi di quella che considerava una “dottrina metafisica”, ossia che dagli stessi antecedenti derivino conseguenze simili. Da un punto di vista matematico furono i contributi di Henri Poincaré e Mark Kac a farci comprendere la fallacia dell’approccio: la chiave è che anche in un sistema deterministico il tempo necessario perché il sistema evolva in uno stato simile a quanto già osservato in passato è tanto maggiore quanto meno probabile è questo stato. Benché in linea di principio si possa catturare la complessità di un dato fenomeno a partire dalle serie temporali delle sue osservazioni, dal punto di vista pratico tale operazione è resa impossibile non appena la complessità del fenomeno è minimamente grande. È il caso delle previsioni del tempo, oggi basate sulla simulazione di un modello matematico che ci permette, con l’aiuto determinante di dati sulle serie storiche, di proiettare il sistema nel futuro generando gli scenari più attendibili. Da tutto ciò evinciamo che un compromesso intelligente tra modellizzazione teorica e machine learning sembra essere la migliore strategia di previsione. Chiediamoci ora se il metodo degli analoghi, e più in generale la strategia di guardare al futuro con gli occhi del passato, non sia problematica anche per quelle che oggi chiamiamo intelligenze artificiali guidate da algoritmi di machine learning. Esemplare, a tal proposito, è il caso delle auto senza guidatore della Volvo che, come riportato dal Guardian nell’estate del 2017 (vd. link sul web), si bloccarono totalmente davanti ai canguri australiani. Essendo macchine svedesi, “addestrate” su esempi di alci e renne, il primo incontro con un canguro si rivelò per loro un’esperienza incomprensibile. Questo esempio ci permette di mettere a fuoco una limitazione fondamentale degli attuali “algoritmi di inferenza”, ossia di quel complesso di tecniche, sviluppate nella teoria della probabilità, che permettono di dedurre regolarità (in inglese “patterns”) a partire da moli di dati, e stimare la probabilità di eventi futuri basandoci sull’osservazione del passato. L’enigma su cui generazioni di scienziati si sono misurati può essere enunciato nel modo seguente: come possiamo stimare la probabilità di un evento che non si è mai verificato in precedenza? Non ne abbiamo la minima idea! Questo è un problema molto generale, che riguarda anche le cosiddette macchine “intelligenti”. Il problema generale con cui umani e macchine si confrontano è quello del nuovo, di comprendere cioè cosa sarà possibile e, ancor di più, quale dei futuri possibili ha maggiori probabilità di realizzarsi. Queste considerazioni sono state splendidamente riassunte dal famoso biologo e scienziato dei sistemi complessi Stuart Kauffman. Kauffman ha coniato il termine “adiacente possibile”, per indicare tutte quelle cose (che siano molecole, idee o strumenti tecnologici) che sono a un passo da ciò che esiste realmente e che quindi possono derivare da modifiche incrementali e ricombinazioni di materiale esistente (vd. fig. d, ndr). Nelle parole di Steven Johnson (giornalista e scrittore che si occupa di innovazione tecnologica): “La strana e bella verità sull’adiacente possibile è che i suoi confini crescono man mano che si esplorano”. Questo è il punto chiave dell’adiacente possibile: l’espansione (o la ristrutturazione) dello spazio delle possibilità, condizionata all’esplorazione dello spazio stesso e all’esperienza del nuovo. La nozione di adiacente possibile è affascinante. Racconta una storia su uno spazio, lo spazio delle possibilità, molto difficile da tracciare. Eppure questo è lo spazio che esploriamo e modifichiamo costantemente nella nostra vita quotidiana mentre prendiamo decisioni e agiamo. Sarebbe desiderabile sapere molto di più su questo spazio, sulla sua struttura, sulla sua ristrutturazione, sulle sue dinamiche, sul modo in cui lo esploriamo, individualmente o collettivamente. Recentemente, in collaborazione con Vito Servedio, Steven Strogatz e Francesca Tria, abbiamo introdotto una struttura matematica per indagare le dinamiche del nuovo attraverso l’adiacente possibile. Il modello teorico fornisce una struttura matematica all’idea dell’adiacente possibile e sviluppa l’idea che i processi di innovazione non siano lineari e che le condizioni per il verificarsi di un determinato evento potrebbero realizzarsi solo dopo che è successo qualcos’altro. YouTube, per esempio, non avrebbe potuto svilupparsi prima dell’avvento della banda larga.

L’espansione dell’adiacente possibile, condizionata al verificarsi di una novità, è l’ingrediente cruciale in questo schema teorico, per derivare previsioni testabili e quantitative. Per esempio, le previsioni sul tasso di innovazione, cioè della velocità con cui osserviamo nuove cose, insieme alle correlazioni tra eventi di innovazione, l’emergere di ondate di novità, tendenze, ecc. Le previsioni basate sulla nozione di adiacente possibile sono state validate in moltissimi sistemi sociali e tecnologici: dalla scrittura di testi allo sviluppo collaborativo delle pagine di Wikipedia, dalla fruizione della musica alla scrittura di open software, dalla creazione di hashtag su Twitter alla scrittura di brevetti. Si può dire che, al di là di una sterile contrapposizione tra intelligenza umana e intelligenza artificiale, per affrontare le sfide scientifiche e sociali del futuro sarebbe interessante potersi muovere verso una cosiddetta “creatività aumentata”. Questo implica comprendere in che modo la straordinaria capacità umana di creare, di concepire modelli e intuire soluzioni possa essere supportata dalle nuove tecnologie nella ricerca di percorsi rari che possano portare a innovazioni utili e dirompenti. Forse ci è data un’opportunità unica per innescare un circolo virtuoso, in cui le macchine possono evolversi per imparare dalla natura ancora inafferrabile della creatività umana e gli esseri umani possono essere stimolati e sfidati nelle loro attività creative dall’onnipresenza di una nuova generazione di macchine. Con un minimo di riflessione, possiamo identificare due meccanismi principali attraverso i quali le macchine ci stanno già aiutando a essere più creativi. Da un lato c’è quello che potremmo definire un supporto “passivo”. L’esempio forse più eclatante è la sfida che ha opposto AlphaGo, un programma per computer che riproduce il gioco da tavolo Go, a Lee Sedol, uno dei migliori giocatori di Go di sempre. Sedol ha perso 4 partite su 5 ed è riuscito a vincere una sola partita grazie a una mossa straordinariamente sorprendente, divenuta famosa tra gli esperti come “mossa 78”. AlphaGo ha semplicemente giudicato quella mossa troppo improbabile (uno su diecimila) da giocare e quella mossa è stata la pietra angolare dell’unica vittoria di Lee Sedol.

In questo caso specifico, la macchina programmata per vincere in modo efficiente i giochi di Go ha creato la condizione per Lee Sedol di andare oltre i suoi limiti e trovare una soluzione originale per il cambio di passo. Un altro modo, forse ancora più interessante, in cui le macchine possono supportare e aumentare la nostra creatività, è attraverso un ruolo più attivo. Invece di creare ostacoli da superare, le macchine potrebbero suggerire nuovi percorsi da esplorare nello spazio dell’adiacente possibile. Percorsi forse molto rari, che potrebbero stimolare ulteriormente l’immaginazione umana circa i loro potenziali esiti. Gli esempi sono davvero molti. È ad esempio il caso dei progetti di strumenti di co-creazione per musica o testi. O dei progetti per la creazione di piattaforme per la sostenibilità, il cui obiettivo è quello di comprendere il presente, attraverso i dati, e proiettarlo nel futuro attraverso una previsione realistica di come un cambiamento nelle condizioni attuali influenzerà e modificherà lo scenario futuro (i cosiddetti “whatif games”). Anche in questo caso l’idea è di supportare la creatività umana nella ricerca di nuove soluzioni efficaci e sostenibili con l’aiuto di tecniche di apprendimento automatico o di agenti personali artificiali. Il percorso verso gli scenari sopra menzionati è lungi dall’essere lineare e facile. Se l’intelligenza artificiale può trattare sorprendentemente bene “problemi difficili”, ha difficoltà a capire i contesti e le strategie da adottare in ambienti mutevoli. Ancora più difficile è la nuda applicazione delle tecniche di intelligenza artificiale in situazioni in cui lo spazio delle possibilità non è solo ampio e complesso, ma anche aperto. Ciò implica un cambio di paradigma: inventare nuove soluzioni invece di cercare soluzioni. E questa è la situazione più comune quando si svolge ricerca scientifica, quando si affrontano problemi sociali complessi, quando si apprende o quando ci si esprime artisticamente. Secondo qualcuno, l’autoreferenzialità – intesa come l’abilità di un sistema cognitivo di osservare sé stesso da un livello più alto di astrazione – è una chiave per capire veramente l’intelligenza. Sulla stessa linea, l’interazione tra intelligenza umana e artificiale potrebbe essere fondamentale anche per capire meglio i percorsi cognitivi alla base della nostra intelligenza e sfruttarli per affrontare efficacemente le sfide della società.